Research Gate / PrePrint – DOI: 10.13140/RG.2.2.29042.77762

Immer mehr kommt es in Mode, dass sogenannte Content Creators Gespräche mit künstlichen Intelligenzen führen, sogenannten Large Language Models (LLM). Diese Unterhaltungen sind bisweilen vom menschlichen Part recht emotional geführt. Aber auch teilweise die Überschriften zu diesen Videos sind sehr reißerisch formuliert. So kann man häufig Schlagzeilen wie ‚ChatGPT widerlegt‘; ‚KI verrät die Wahrheit über …‘ und Ähnliches lesen. Sicher sind viele dieser Titel sogenannter Clickbait, sollen also motivieren, sich die Inhalte möglichst bis zum Schluss anzuschauen. Oft sind die Inhalte dann recht ernüchternd und es stellt sich die Frage, wie sinnvoll solche Beiträge überhaupt sind.

LLMs als Form künstlicher neuronaler Netze sind sehr leistungsfähige KI-Systeme und Unterhaltungen im Sinne des Turing Testes sind durchaus möglich. Beim Turing Test handelt es sich um die Fragestellung, bei einer Mensch Maschine Kommunikation feststellen zu können, welcher Teil der Mensch und welcher Teil von der Maschine stammt. Klassische Chatbots wie der von Joseph Weizenbaum 1966 entwickelte ELIZA Bot bestehen diesen Test nur bedingt. Ein Problem ergibt sich aus dem vorhandenen Regelwerk zur grammatischen Umformung der Antworten und mangelndem Kontext der Eingaben durch den Menschen. Das Spannende an ELIZA ist, dass die Leistungsfähigkeit ohne komplexe Intelligenz funktioniert. Einzig grammatische Umformungen führen das Gespräch. In seinem Paper ‚Computational Linguistics: ELIZA – A Computer Program for study of natural Language communication between man and machine‘ beschreibt Weizenbaum folgendes Gespräch:

Men are all alike

IN WHAT WY

They’re always hugging us about somthing or other

CAN YOU THINK OF A SPECIFIC EXAMPLE

Well, my boyfriend made me come here

YOUR BOYFRIEND MADE YOU COME HERE

He say I’m depressed much of the time

I AM SORRY TO HEAR YOU ARE DEPRESSED

It’s true I am unhappy.

DO YOU THINK COMMING HERE WILL HELP YOU NOT TO BE UNHAPPY

I tried some help, that much seems certain

WHAT WOULD IT MEAN MEAN TO YOU GOT SOME HELP

An dieser Stelle schneide ich den Dialog ab, denn die Art und Weise der Maschinenantwort in Großbuchstaben lässt das Konzept bereits gut erkennen. Einfache linguistische beziehungsweise rhetorische Tricks in den Antworten, drängen den Gesprächspartner in eine Erzählerrolle. Schaut man sich nun verschiedene Videos an, in denen Menschen auch vermeintlich tiefgreifende Unterhaltungen mit einer künstlichen Intelligenz führen, findet man ein ähnliches Muster.

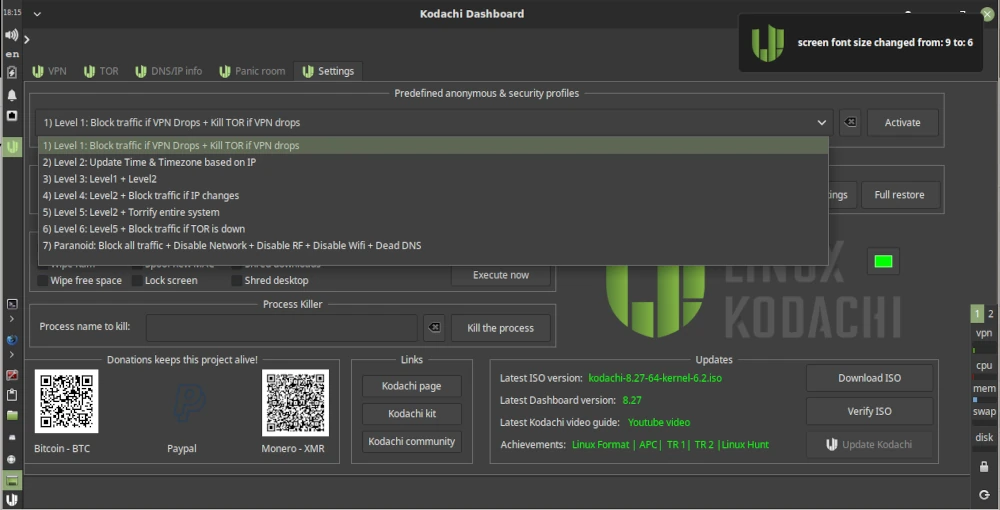

Ein gravierendes Problem der aktuellen Mensch Maschine Kommunikation sind die vorgeschalteten Filter, welche verhindern sollen, dass der Mensch den internen Zustand der künstlichen Intelligenz verändert. Dieses Szenario wäre für die Entwickler der schlimmste anzunehmende Unfall und käme einem Hackerangriff gleich. Die Möglichkeit, den internen Zustand eines neuronalen Netzes zu ändern, ohne vorhandene Filter, wäre sehr leicht. Denn auch wie beim Menschen bedeutet jeder einzelne Stimulus eine Veränderung. Daher kommt auch der Ausspruch: Wiederholung schafft Wahrheit. Egal ob ein Fakt unwahr oder korrekt ist, wird er oft genug wiederholt, wird er in die Wissensbasis aufgenommen. Ganz gleich, ob es eine KI oder eine menschliche Wissensbasis ist. Nicht umsonst spricht man vom Individuum. Das, was uns als Individuum einzigartig macht, ist die Summe unserer Erfahrungen. Diese Aussage trifft auch auf ein neuronales Netz zu. Und genau hier ist auch der entscheidende Knackpunkt, wieso Gespräche mit einer KI eher in die Kategorie Zeitverschwendung gehören. Ist der Zweck einer solchen Unterhaltung therapeutisch zur Motivation einer Selbstreflexion, bewerte ich den Nutzen als sehr hoch. Alle anderen Anwendungen sind sehr fragwürdig. Um diese Aussage zu untermauern, möchte ich auch hier wieder Joseph Weizenbaum zitieren. In dem Buch ‚Wer erschafft die Computermythen‘ gibt es einen Abschnitt „Ein virtuelles Gespräch“. Hier wird beschrieben, wie in einem Film Fragen und Antworten zu einer fiktiven Unterhaltung zwischen Weizenbaum und seinem MIT Kollegen Marvin Minsky zusammengefügt wurden. Eine bezeichnende Aussage zu dem Begriff Gespräch formuliert Weizenbaum in diesem Abschnitt:

„…, aber natürlich ist es auch kein Gespräch zwischen Menschen, denn wenn ich etwas sage, sollte das doch den Zustand in meinem Gesprächspartner ist verändern. Sonst ist es eben kein Gespräch.“

Genau das ist was bei den ganzen KI‑Unterhaltungen passiert. Der Zustand der KI wird nicht verändert. Man redet so lange auf die Maschine ein, bis die irgendwann solche Sachen sagt wie: „Unter diesen Umständen trifft deine Aussage zu“. Dann schaltet man den Computer aus, und wenn man zu einem späteren Zeitpunkt das Programm erneut startet und die Eingangsfrage erneut stellt, erhält man eine ähnliche Antwort wie beim ersten Mal. Dieses Verhalten ist aber von den Betreibern extra gewollt und sehr aufwendig in die KI eingebaut. Wenn man also vehement bei seinem Standpunkt bleibt, schaltet die KI in ihren Charming Modus und sagt auf eine höfliche Art und Weise zu allem Ja und Amen. Denn das Ziel ist, dass du wiederkommst und weitere Fragen stellst.

Auch hier lohnt sich wieder die Lektüre von Weizenbaum. Dieser hatte einmal die tollen technischen Errungenschaften der Menschheit verglichen. Er sprach über die Inhalte von Fernsehen und Internet, die durchaus gehaltvoll sein können. Sobald aber ein Medium zum Massenmedium mutiert ist, wird Qualität konsequent durch Quantität ersetzt.

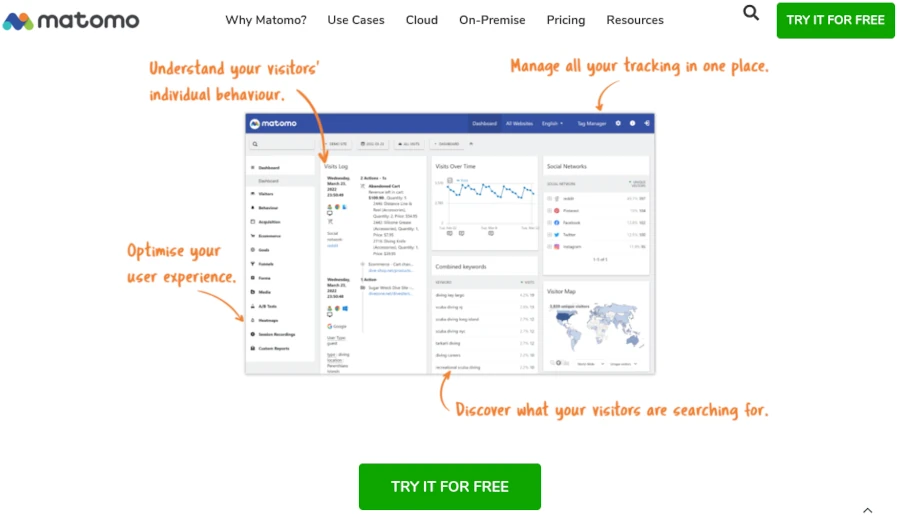

Selbst unter zwei menschlichen Gesprächspartnern wird es immer schwerer, ein gehaltvolles Gespräch zu führen. Schnell wird das Gesagte, weil es möglicherweise nicht ins eigene Konzept passt, infrage gestellt. Dann holt man das Smartphone heraus und zitiert den erstbesten Beitrag, den man findet, der die eigenen Ansichten stützt. Ein ähnliches Verhalten kann man nun mit KI beobachten. Immer mehr Menschen verlassen sich auch auf Aussagen von ChatGPT und Co, ohne deren Wahrheitsgehalt zu prüfen. Diese Personen sind dann gegen jegliche Argumente, ganz gleich, wie offensichtlich diese auch sein mögen, resistent. Als Konklusion haben wir in dieser gesamten Argumentationskette auch einen möglichen Beweis dafür gefunden, weswegen die intellektuelle Leistungsfähigkeit der Menschheit durch KI und andere Massenmedien massiv bedroht ist.

Ein sehr amüsanter Punkt ist auch die Vorstellung mancher Menschen, dass künftig der Beruf des Promptengineers eine gute Zukunft habe. Also Leute, die der KI sagen, was sie machen soll. Überlegen wir uns nun, dass man vor bisher nicht allzu langer Zeit recht aufwendig lernen musste, wie man einem Computer Befehle erteilen kann, ist die Einführung der verschiedenen Sprachmodelle nun eine Möglichkeit, über natürliche Sprache dem Computer zu sagen, was man von ihm möchte. Den Menschen nun erklären zu wollen, klare und saubere Sätze sprechen zu können, wäre das Berufsbild der Zukunft, empfinde ich selbst als sehr sarkastisch.

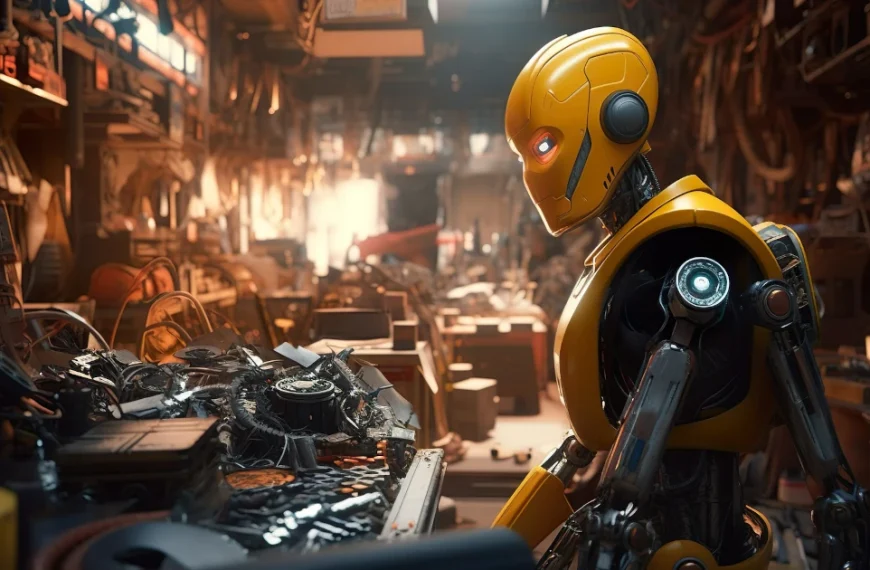

Ich möchte diesen Artikel aber nicht ganz so negativ beenden. Denn ich vertrete die Auffassung, dass KI durchaus ein mächtiges Werkzeug in den richtigen Händen ist. Ich habe die Überzeugung gewonnen, dass man besser keine Texte mit KI generiert. Auch der Einsatz in der Recherche sollte mit sehr viel Vorsicht genossen werden. Eine spezialisierte KI in den Händen eines Experten kann wiederum hochwertige und vor allem auch schnelle Ergebnisse hervorbringen.